发布于 5 个月前

发布于 5 个月前

烟璃悠

更新于 5 个月前

2

0

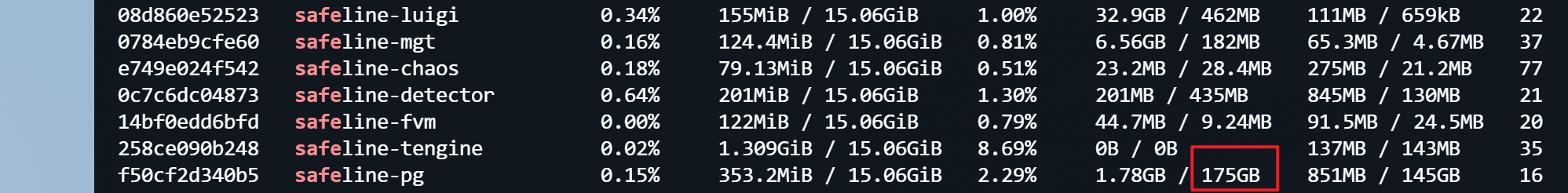

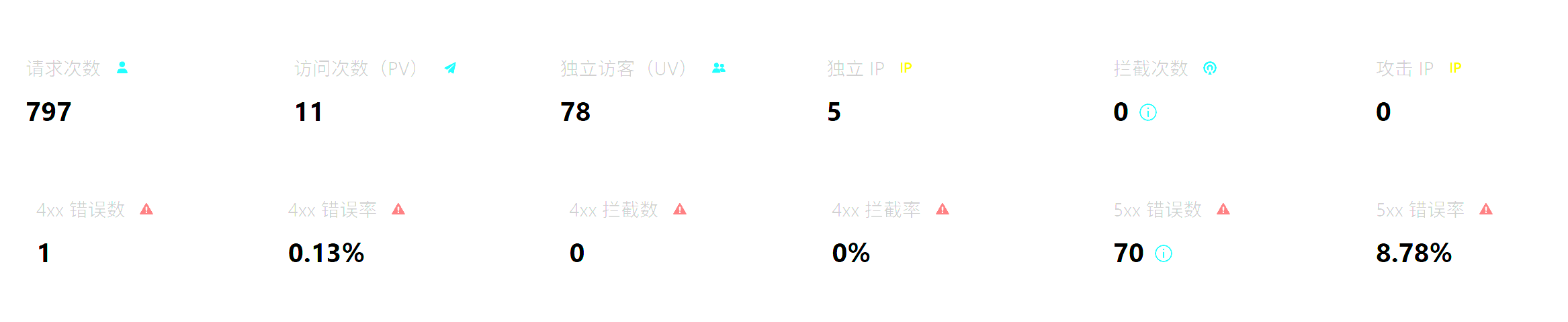

监控容器使用情况的时候,发现PG写入数据库的数据量特别大。我的网站本身流量并不大,想咨询一下这个数据规模为何这么大,是什么会导致如此大量写入。下面的数据容器启动了仅8天。

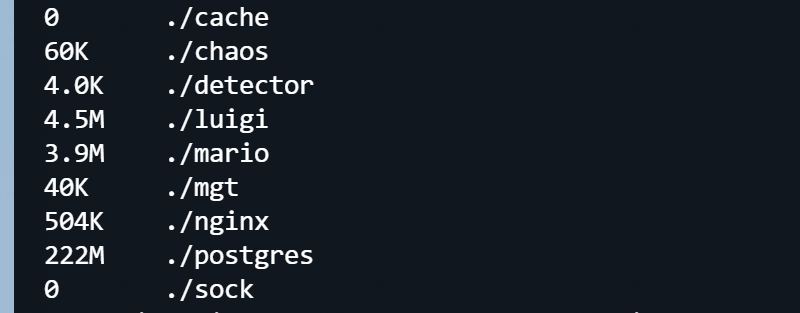

另外也补充一下持久化的数据尺寸,看起来也并不大

Qazwsxedc

更新于 5 个月前

0

0

主要有管理服务和数据库之间之前的数据传输,包括配置下发,统计上报等数据,这个统计只适用于容器网络接口的数据传输量,包括接收和发送的数据量,一般不用太关心

烟璃悠

更新于 5 个月前

首先是个人的几个小服务,流量其实很小,即便真的流量大,我的理解也应该是 tengine,detector之类的服务对外提供流量。

基于这个认识,配置下发和统计上报的流量这么大其实有点无法理解。本身配置没有特别修改,统计上报的数据量应该都是结构化数据,数据量应该很有限,平均每天几十个G的写入,感觉确实有点夸张了。

烟璃悠

更新于 5 个月前

0

0

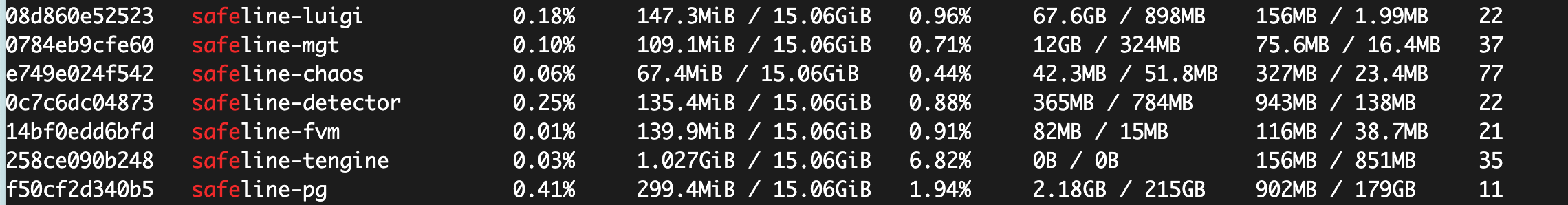

因为本身是固态硬盘,全新盘使用了大概半年,已经2%的寿命耗费掉了。

虽然这个难免,而且不完全是waf的原因,只是另外一个同样的盘用了快2年了,都没有耗掉1%,对比之下有点寿命焦虑

Coco

更新于 5 个月前

我也早在群里反映过了,即使部署后没有打开外部网络也是持续在写入数据,大概每秒500kb,固态硬盘寿命哗哗掉.

Coco

更新于 5 个月前

1

0

我也发现雷池部署后就有持续写入硬盘数据流量,使用虚拟机用docker测试过没有外部访问也有持续写入数据到硬盘.

在没有访问的情况下大概每秒有500kb的数据写入硬盘,每天写入40G的数据.我的固态健康状态哗哗的掉.

烟璃悠

更新于 5 个月前

0

0

赞同,感觉这个确实有点太多了,4G我还能勉强接受,每天40G确实太夸张了。

感觉是不是调查一下根本原因是什么,不然这么大量的数据写入确实无法接受。